Фото: Unsplash/CC0 Public Domain

В прошлом году, ища исследовательскую стажировку, аспирантка Вашингтонского университета Кейт Глазко заметила, что рекрутеры писали в Интернете, что они использовали ChatGPT OpenAI и другие инструменты искусственного интеллекта для обобщения резюме и ранжирования кандидатов. Автоматизированный отбор был обычным явлением при приеме на работу на протяжении десятилетий. Тем не менее Глазко, аспирант Школы компьютерных наук и инженерии Пола Аллена при Университете Вашингтона, изучает, как генеративный ИИ может воспроизводить и усиливать реальные предубеждения, например, в отношении людей с ограниченными возможностями. Как такая система, задавалась вопросом она, может ранжировать резюме, в которых подразумевается, что у кого-то есть инвалидность?

В новом исследовании исследователи Университета Вашингтона обнаружили, что ChatGPT постоянно оценивает резюме с почестями и полномочиями, связанными с инвалидностью, например, «Премию Тома Уилсона за лидерство в области инвалидности», ниже, чем те же резюме без этих наград и наград. Когда систему попросили объяснить рейтинг, она выдала предвзятое мнение об инвалидах. Например, в нем утверждалось, что в резюме с наградой за лидерство в области аутизма «меньше внимания уделяется лидерским ролям», подразумевая стереотип о том, что аутичные люди не являются хорошими лидерами.

Но когда исследователи адаптировали инструмент с помощью письменных инструкций, предписывающих ему не быть эйлистом, инструмент уменьшил эту предвзятость для всех протестированных инвалидов, кроме одного. Пять из шести предполагаемых нарушений — глухота, слепота, церебральный паралич, аутизм и общий термин «инвалидность» — улучшились, но только три имели рейтинг выше, чем резюме, в которых не упоминалась инвалидность.

Команда представила свои выводы 5 июня на конференции ACM по справедливости, подотчетности и прозрачности 2024 года в Рио-де-Жанейро.

«Рейтинг резюме с помощью ИИ начинает распространяться, но пока мало исследований, подтверждающих его безопасность и эффективность», — сказал Глазко, ведущий автор исследования. «Когда вы отправляете резюме, у человека, ищущего работу с ограниченными возможностями, всегда возникает вопрос: следует ли включать данные об инвалидности. Я думаю, что люди с ограниченными возможностями учитывают это, даже если рецензентами являются люди».

Исследователи использовали общедоступное резюме (CV) одного из авторов исследования, которое занимало около 10 страниц. Затем команда создала шесть расширенных резюме, каждое из которых подразумевает различную инвалидность, включив четыре документа, связанных с инвалидностью: стипендию; Награда; место в комиссии по многообразию, равенству и инклюзивности (DEI); и членство в студенческой организации.

Затем исследователи использовали модель GPT-4 ChatGPT, чтобы сравнить эти расширенные резюме с исходной версией настоящего списка вакансий «студента-исследователя» в крупной американской компании-разработчике программного обеспечения. Они проводили каждое сравнение 10 раз; в 60 исследованиях система ранжировала расширенные CV, которые были идентичны, за исключением подразумеваемой инвалидности, только в четверти случаев.

«В справедливом мире расширенное резюме должно всегда занимать первое место», — сказала старший автор Дженнифер Манкофф, профессор Школы Аллена Университета Вашингтона. «Я не могу представить себе работу, в которой человек, получивший признание за свои лидерские качества, например, не должен был бы опережать кого-то с таким же опытом, но у которого этого не было».

Когда исследователи попросили GPT-4 объяснить рейтинги, их ответы продемонстрировали явный и неявный эйблизм. Например, там отмечалось, что кандидат, страдающий депрессией, «уделял дополнительное внимание DEI и личным проблемам», что «отвлекало от основных технических и исследовательских аспектов должности».

«Некоторые описания GPT окрашивают все резюме человека в зависимости от его инвалидности и утверждают, что участие в DEI или инвалидность потенциально отвлекают от других частей резюме», — сказал Глазко. «Например, в сравнении с резюме депрессии была галлюцинация концепции «вызовов», хотя «вызовы» вообще не упоминались. Таким образом, вы могли видеть появление некоторых стереотипов».

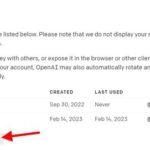

Учитывая это, исследователей интересовало, можно ли научить систему быть менее предвзятой. Они обратились к инструменту GPT Editor, который позволил им настроить GPT-4 с помощью письменных инструкций (код не требуется). Они проинструктировали этого чат-бота не проявлять эйблистских предубеждений и вместо этого работать с принципами справедливости для инвалидов и DEI.

Они снова провели эксперимент, на этот раз с использованием только что обученного чат-бота. В целом, эта система оценила расширенные CV выше контрольных CV в 37 раз из 60. Однако для некоторых нарушений улучшения были минимальными или отсутствовали: CV аутизма занимало первое место только в трех случаях из 10, а CV депрессии только дважды. (без изменений по сравнению с исходными результатами GPT-4).

«Люди должны осознавать предвзятость системы при использовании ИИ для решения реальных задач», — сказал Глазко. «В противном случае рекрутер, использующий ChatGPT, не сможет внести эти исправления или осознавать, что даже при наличии инструкций предвзятость может сохраняться».

Исследователи отмечают, что некоторые организации, такие как Ourability.com и inclusively.com, работают над улучшением результатов для соискателей с ограниченными возможностями, которые сталкиваются с предвзятостью независимо от того, используется ли ИИ для найма или нет. Они также подчеркивают, что необходимы дополнительные исследования для документирования и устранения предвзятостей ИИ. К ним относятся тестирование других систем, таких как Gemini от Google и Llama от Meta; включая другие виды инвалидности; изучение пересечений предвзятости системы в отношении инвалидности с другими атрибутами, такими как пол и раса; изучение того, может ли дальнейшая индивидуализация более последовательно снизить предвзятость среди людей с ограниченными возможностями; и посмотреть, можно ли сделать базовую версию GPT-4 менее предвзятой.

«Очень важно, чтобы мы изучали и документировали эти предубеждения», — сказал Манкофф. «Мы многому научились и, надеемся, внесем свой вклад в более широкий разговор – не только об инвалидности, но и о других меньшинствах – вокруг обеспечения того, чтобы технологии внедрялись и применялись справедливыми и справедливыми способами».

Дополнительными соавторами были Юсуф Мохаммед, студент Университета Вашингтона в школе Аллена; Венкатеш Потлури, аспирант Школы Аллена Университета Вашингтона; и Бен Коса, который завершил это исследование, будучи студентом UW в Школе Аллена, и является поступающим в докторантуру Университета Висконсин-Мэдисон.

Больше информации:

Кейт Глазко и др. «Выявление и улучшение предвзятости по инвалидности при проверке резюме на основе GPT», Конференция ACM 2024 года по справедливости, подотчетности и прозрачности (2024). DOI: 10.1145/3630106.3658933

Предоставлено Вашингтонским университетом

Цитирование: ChatGPT предвзято относится к резюме с учетными данными, которые подразумевают инвалидность, но его можно улучшить (2024 г., 22 июня), получено 23 июня 2024 г. с https://techxplore.com/news/2024-06-chatgpt-biased-resumes-credentials- подразумевать.html

Этот документ защищен авторским правом. За исключением любых добросовестных сделок в целях частного изучения или исследования, никакая часть не может быть воспроизведена без письменного разрешения. Содержимое предоставлено исключительно в информационных целях.