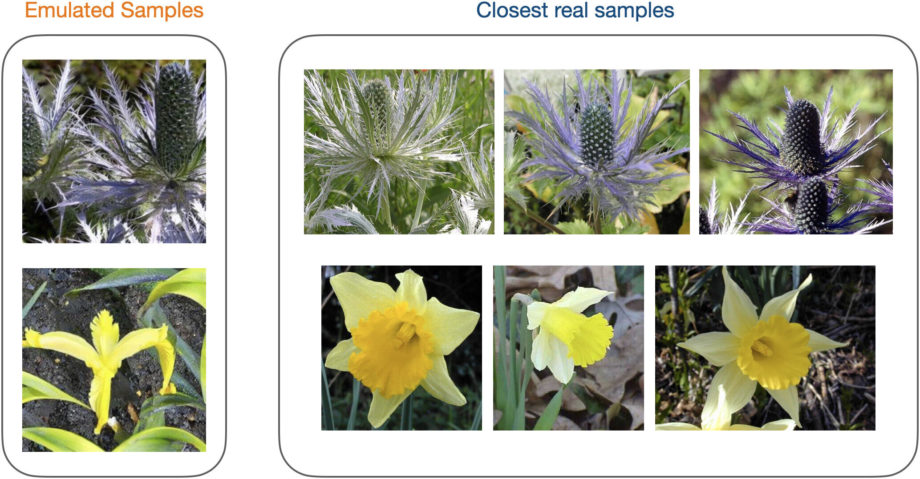

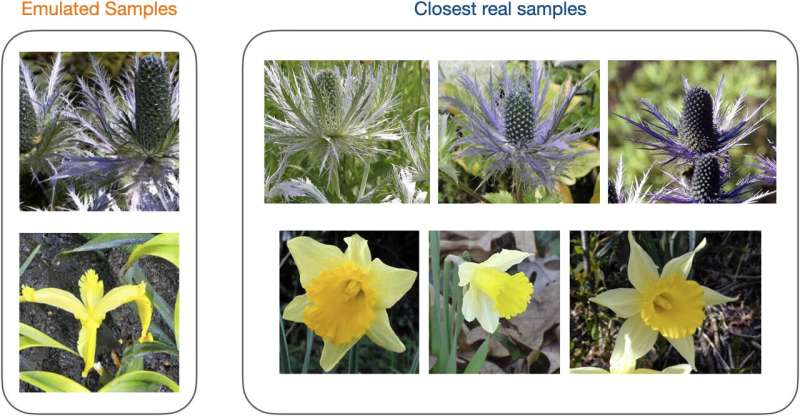

Пример эмуляции набора данных. Мы показываем образцы эмулированного набора данных Oxford Flowers, который фиксирует исходное распределение, сохраняя при этом большое расстояние CLIP от исходных данных. Кредит: Труды Национальной академии наук (2024). DOI: 10.1073/pnas.2307304121

На сегодняшний день проблемы, связанные с генеративным искусственным интеллектом, ни для кого не секрет. Известно, что такие модели, как ChatGPT от OpenAI, Claude от Anthropic и Llama от Meta, «галлюцинируют», придумывая потенциально вводящие в заблуждение ответы, а также разглашают конфиденциальную информацию, например, материалы, защищенные авторским правом.

Одним из потенциальных решений некоторых из этих проблем является «извлечение моделей» — набор методов, которые заставляют модели очищать себя от контента, который приводит к нарушению авторских прав или предвзятым реакциям.

В статье в Труды Национальной академии наукМайкл Кернс, профессор Национального центра управления и технологий в области компьютерных и информационных наук (СНГ), и трое коллег-исследователей из Amazon делятся своим мнением о потенциале искажения моделей для решения некоторых проблем, с которыми сегодня сталкиваются модели ИИ.

В следующих вопросах и ответах Кернс обсуждает статью и ее значение для улучшения ИИ.

Содержание

- 1 Что такое дегоржаж модели?

- 2 Чем искажение моделей отличается от усилий по обеспечению конфиденциальности данных, таких как Общий регламент по защите данных в Европе?

- 3 «Этический алгоритм», который вы написали в соавторстве с Аароном Ротом, профессором компьютерных и когнитивных наук Генри Сальватори в СНГ, и на который вы недавно ссылались в контексте ИИ, описывает, как внедрить этические соображения в разработку алгоритма. Будет ли такой подход осуществим с моделями ИИ?

- 4 Можно ли фильтровать данные обучения для моделей ИИ, чтобы снизить вероятность предвзятых ответов или ответов, нарушающих авторские права?

- 5 Можете ли вы привести несколько примеров методов дегоржажа модели? Как они работают?

- 6 Если бы мы могли вернуться в прошлое и изменить способ устройства Интернета, могли бы мы быть уверены, что каждый фрагмент данных в Интернете был помечен или идентифицирован с разными уровнями защиты, чтобы сбор данных из Интернета давал метаданные, которые информировали бы о том, что могут модели ИИ и нельзя использовать в тренировках?

- 7 В вашей недавней статье вы и ваши соавторы систематизировали обсуждавшиеся выше модельные методы извержения в таксономию, классифицируя их в зависимости от того, когда они применяются и как они работают. Что, по вашему мнению, эта статья предложит будущим исследователям и специалистам отрасли?

Что такое дегоржаж модели?

Дегоржаж модели — это название широкого набора методов и проблем, которые эти методы пытаются решить. Цель состоит в том, чтобы смягчить или устранить влияние определенных фрагментов обучающих данных на поведение обученной модели.

Вы ожидаете, что отдельные фрагменты обучающих данных или коллекции обучающих данных будут влиять на поведение модели. Но это может привести к утечке конфиденциальной информации, нарушению авторских прав и другим проблемам, которые пока не урегулированы законом.

Чем искажение моделей отличается от усилий по обеспечению конфиденциальности данных, таких как Общий регламент по защите данных в Европе?

Это разные, но связанные проблемы. Если я попрошу Facebook удалить всю мою сохраненную активность в Facebook со своих серверов, GDPR требует, чтобы это было сделано по запросу.

Такие законы, как GDPR, менее четко описывают, что происходит перед удалением ваших данных. Ваши данные использовались для обучения прогнозной модели, и эта прогнозирующая модель все еще существует и работает по всему миру. Эта модель все равно будет обучена на ваших данных даже после того, как ваши данные будут удалены с серверов Facebook. Это может привести к ряду проблем.

Во-первых, если ваши данные были конфиденциальными, сторонний злоумышленник мог бы провести реверс-инжиниринг конфиденциальных аспектов ваших личных данных. Это, безусловно, тот случай, когда вы хотели бы, чтобы методы искажения модели удалили из модели эти конфиденциальные данные.

Кроме того, существуют проблемы с авторским правом, как мы видим в иске The New York Times против OpenAI. ChatGPT может воспроизводить дословно защищенные авторским правом статьи из Times. Совершенно очевидно, что OpenAI использовала эти статьи при обучении ChatGPT.

Чтобы внести ясность: газета не хочет, чтобы эти статьи были конфиденциальными; он хочет, чтобы статьи были доступны публике. Но Times также хочет контролировать использование и воспроизведение статей.

Наконец, есть еще одна проблема, которую я мог бы назвать «стилистическим нарушением», когда пользователь может сказать: «Дайте мне картину в стиле Энди Уорхола, на которой изображен кот, катающийся на скейтборде на Риттенхаус-сквер». Модель способна хорошо выполнять свою работу, поскольку прошла обучение на протяжении всей карьеры Энди Уорхола. Если вы распорядитель имущества Энди Уорхола, вы можете с этим не согласиться.

Несмотря на то, что это очень разные проблемы, технические способы их решения весьма схожи и включают в себя методы дегоржажа модели. Другими словами, дело не в том, что искажение модели отличается от усилий по обеспечению конфиденциальности данных, а скорее в том, что методы искажения модели могут использоваться в определенных ситуациях, когда нынешние подходы к конфиденциальности, такие как GDPR, не оправдывают ожиданий.

«Этический алгоритм», который вы написали в соавторстве с Аароном Ротом, профессором компьютерных и когнитивных наук Генри Сальватори в СНГ, и на который вы недавно ссылались в контексте ИИ, описывает, как внедрить этические соображения в разработку алгоритма. Будет ли такой подход осуществим с моделями ИИ?

Когда мы писали книгу, генеративного ИИ еще не существовало, по крайней мере, в том виде, в котором он существует сегодня. Наша книга посвящена традиционному машинному обучению, которое включает в себя более целенаправленные прогнозы — например, получение информации из заявки на кредит и оценку риска того, что конкретный человек не сможет выполнить свои обязательства, если ему выдадут кредит.

Когда приложение является таким целевым, становится гораздо проще внедрить в процесс обучения защиту от различных опасностей, которые вас беспокоят, таких как демографическая предвзятость в производительности модели или утечка частных данных обучения.

На данный момент мы утратили эту способность при обучении генеративных моделей из-за чрезвычайно открытого характера их результатов.

Можно ли фильтровать данные обучения для моделей ИИ, чтобы снизить вероятность предвзятых ответов или ответов, нарушающих авторские права?

Это сложно по нескольким причинам.

Чтобы обучить конкурентоспособную модель большого языка, нужно буквально очистить весь Интернет. Это ставки на столе. Вам также понадобится множество других, более частных источников данных. Когда это отправная точка, вы очень многого не знаете о своих тренировочных данных.

В принципе, мы знаем, как обучать огромные нейронные сети таким образом, чтобы избежать всех этих проблем. Вы можете обучить нейронную сеть в условиях дифференциальной конфиденциальности, например, метода преднамеренного повреждения данных для защиты конфиденциальной информации, и таких проблем будет возникать меньше.

Никто не пробовал. Я думаю, что общее мнение таково, что снижение производительности, которое вы получите при обучении большой языковой модели в условиях ограничения дифференциальной конфиденциальности, в первую очередь устранит этот вопрос.

Другими словами, качество будет настолько плохим, что вы начнете генерировать бессмысленные, неграмматические результаты. Количество шума, которое вам нужно будет добавить в процесс обучения (именно так работает дифференциальная конфиденциальность), просто не будет работать в больших масштабах.

Можете ли вы привести несколько примеров методов дегоржажа модели? Как они работают?

Одним из концептуально простых решений является переобучение с нуля. Это явно неосуществимо, учитывая масштаб и размер этих сетей, а также время вычислений и ресурсы, необходимые для их обучения. В то же время переподготовка — это своего рода золотой стандарт: то, чего вы хотели бы достичь более эффективным и масштабируемым способом.

Тогда есть «алгоритмические» решения. Одним из них является машинное «отучивание». Вместо того, чтобы переобучать всю сеть, мы могли бы просто изменить ее каким-либо образом, чтобы смягчить или уменьшить влияние ваших данных на процесс обучения.

Другой алгоритмический подход — обучение в условиях дифференциальной конфиденциальности: добавление шума в процесс обучения таким образом, чтобы минимизировать влияние любого конкретного фрагмента обучающих данных, при этом позволяя использовать совокупные свойства набора данных.

Кроме того, есть то, что я мог бы назвать методами системного уровня. Одним из них является «шардинг». Если бы я разделил свои обучающие данные на 100 «осколков», я мог бы обучить другую модель на каждом из этих 100 сегментов, а затем создать общую модель, усреднив эти 100 моделей.

Если нам повезет, что ваши данные находились только в одном из этих 100 сегментов, и вы захотите удалить свои данные, мы могли бы просто полностью удалить эту модель из среднего значения. Или мы могли бы переобучить только эту модель, которая использовала только один процент от общего объема данных.

Вклад ваших данных в что-то вроде ChatGPT весьма незначителен. Если бы вы применили метод сегментирования, ваши данные, скорее всего, полностью попали бы в один, максимум два из этих 100 сегментов.

Большую озабоченность вызывают действительно большие наборы данных. Как вы можете быть уверены, что каждая организация, данные которой вы используете, находится только в одном из 100 сегментов?

Чтобы организовать это, вы должны заранее знать, что это за организации — и это возвращает нас к моему предыдущему замечанию о том, что часто вы не знаете, что находится в ваших данных обучения.

Если мои обучающие данные представляют собой какой-то массивный файл, который сканирует весь Интернет, и я разбиваю его на 100 частей, я понятия не имею, где данные Getty Images могут быть распределены между этими сотнями частей.

Если бы мы могли вернуться в прошлое и изменить способ устройства Интернета, могли бы мы быть уверены, что каждый фрагмент данных в Интернете был помечен или идентифицирован с разными уровнями защиты, чтобы сбор данных из Интернета давал метаданные, которые информировали бы о том, что могут модели ИИ и нельзя использовать в тренировках?

Моя интуиция такова, что этот подход может помочь решить проблемы, которые мы здесь обсуждаем, но, возможно, привел бы к совершенно другим проблемам в других местах.

Одним из величайших успехов потребительского Интернета стала его открытость и отсутствие структуры и правил организации данных и того, как данные могут перекрестно ссылаться на другие данные. Вы можете представить себе настройку правил по-другому. Но вы также можете представить, что Интернет, возможно, никогда не появится, потому что строить на его основе было бы слишком обременительно.

История великого успеха Интернета возникла, по сути, из-за отсутствия правил. Вы платите за отсутствие правил в тех областях, которые мы здесь сегодня обсуждаем.

Большинство людей, которые серьезно думают о конфиденциальности и безопасности, вероятно, согласятся со мной, что многие из самых больших проблем в этих темах возникают из-за отсутствия правил и дизайна Интернета, но это также то, что сделало его таким доступным и успешным.

Короче говоря, трудно избежать этих компромиссов.

В вашей недавней статье вы и ваши соавторы систематизировали обсуждавшиеся выше модельные методы извержения в таксономию, классифицируя их в зависимости от того, когда они применяются и как они работают. Что, по вашему мнению, эта статья предложит будущим исследователям и специалистам отрасли?

Во многих отношениях это нетехническая статья, предназначенная для более широкой аудитории. Мы надеемся, что статья поможет сформулировать размышления по этим вопросам, в частности, по компромиссам между различными техническими методами извлечения модели. Мне казалось, что эта тема достаточно важна для общества и достаточно зарождалась с научной точки зрения, поэтому сейчас самое время сделать шаг вперед и осмотреть ландшафт.

Больше информации:

Алессандро Ахилле и др., Извержение модели ИИ: методы и варианты, Труды Национальной академии наук (2024). DOI: 10.1073/pnas.2307304121

Предоставлено Пенсильванским университетом

Цитирование: Вопросы и ответы: Изъятие модели — ключ к исправлению предвзятости ИИ и нарушения авторских прав? (2024 г., 17 мая) получено 18 мая 2024 г. с https://techxplore.com/news/2024-05-qa-disgorgement-key-ai-bias.html.

Этот документ защищен авторским правом. За исключением любых добросовестных сделок в целях частного изучения или исследования, никакая часть не может быть воспроизведена без письменного разрешения. Содержимое предоставлено исключительно в информационных целях.